ж–Үз« жҸ’еӣҫ

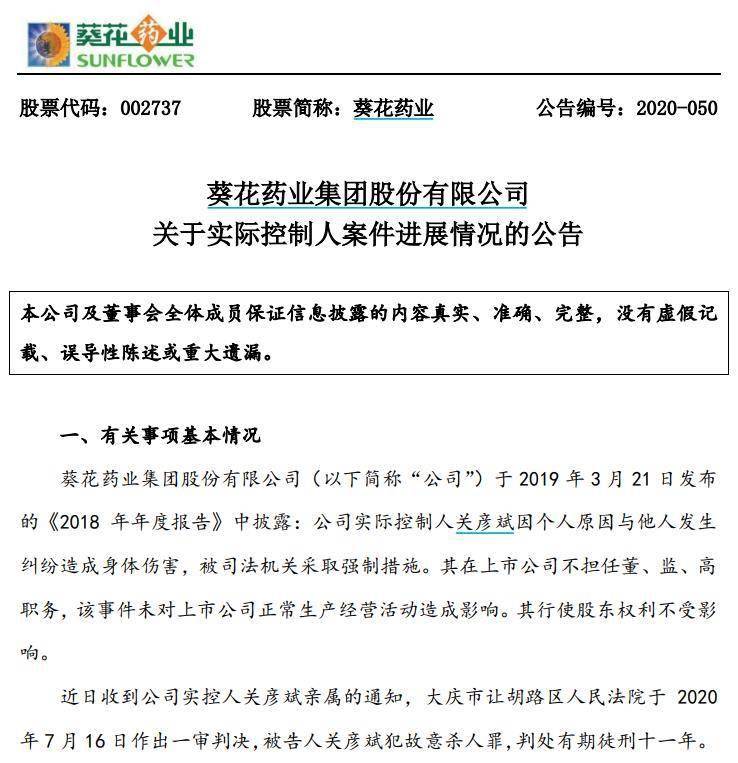

еӣҫзүҮжқҘжәҗпјҡз”ұж— з•Ң AI з”ҹжҲҗ

гҖҗеӨ§жЁЎеһӢеҸҜи§ЈйҮҠжҖ§дҪ иғҪзҗҶеҫ—жё…еҗ—пјҹз»јиҝ°е·ІжқҘпјҢдёҖж–Үи§ЈдҪ з–‘жғ‘гҖ‘еӨ§и§„жЁЎиҜӯиЁҖжЁЎеһӢеңЁиҮӘ然иҜӯиЁҖеӨ„зҗҶж–№йқўеұ•зҺ°еҮәд»ӨдәәжғҠ讶зҡ„жҺЁзҗҶиғҪеҠӣпјҢдҪҶе…¶еҶ…еңЁжңәзҗҶе°ҡдёҚжё…жҷ° гҖӮйҡҸзқҖеӨ§и§„жЁЎиҜӯиЁҖжЁЎеһӢзҡ„е№ҝжіӣеә”з”ЁпјҢйҳҗжҳҺжЁЎеһӢзҡ„иҝҗиЎҢжңәеҲ¶еҜ№еә”з”Ёе®үе…ЁжҖ§гҖҒжҖ§иғҪеұҖйҷҗжҖ§е’ҢеҸҜжҺ§зҡ„зӨҫдјҡеҪұе“ҚиҮіе…ійҮҚиҰҒ гҖӮ

иҝ‘жңҹ пјҢ дёӯзҫҺеӨҡе®¶з ”з©¶жңәжһ„пјҲж–°жіҪиҘҝзҗҶе·ҘеӯҰйҷўгҖҒзәҰзҝ°ж–Ҝ?йңҚжҷ®йҮ‘ж–ҜеӨ§еӯҰгҖҒз»ҙе…ӢжЈ®жһ—еӨ§еӯҰгҖҒдҪҗжІ»дәҡеӨ§еӯҰгҖҒдёҠжө·дәӨеӨ§гҖҒзҷҫеәҰзӯүпјүиҒ”еҗҲеҸ‘еёғдәҶеӨ§жЁЎеһӢеҸҜи§ЈйҮҠжҖ§жҠҖжңҜзҡ„з»јиҝ°пјҢеҲҶеҲ«еҜ№дј з»ҹзҡ„ fine-tuning жЁЎеһӢе’ҢеҹәдәҺ prompting зҡ„и¶…еӨ§жЁЎеһӢзҡ„еҸҜи§ЈйҮҠжҖ§жҠҖжңҜиҝӣиЎҢдәҶе…Ёйқўзҡ„жўізҗҶпјҢ并жҺўи®ЁдәҶжЁЎеһӢи§ЈйҮҠзҡ„иҜ„дј°ж ҮеҮҶе’ҢжңӘжқҘзҡ„з ”з©¶жҢ‘жҲҳ гҖӮ

ж–Үз« жҸ’еӣҫ

- и®әж–Үй“ҫжҺҘпјҡhttps://arxiv.org/abs/2309.01029

- Github й“ҫжҺҘпјҡhttps://github.com/hy-zhao23/Explainability-for-Large-Language-Models

ж–Үз« жҸ’еӣҫ

и§ЈйҮҠеӨ§жЁЎеһӢзҡ„йҡҫзӮ№еңЁд»Җд№Ҳең°ж–№пјҹ

дёәдҪ•и§ЈйҮҠеӨ§жЁЎеһӢжңүзӮ№йҡҫпјҹеӨ§иҜӯиЁҖжЁЎеһӢеңЁиҮӘ然иҜӯиЁҖеӨ„зҗҶд»»еҠЎдёҠзҡ„жғҠиүіиЎЁзҺ°еј•иө·дәҶзӨҫдјҡе№ҝжіӣзҡ„е…іжіЁ гҖӮдёҺжӯӨеҗҢж—¶пјҢеҰӮдҪ•и§ЈйҮҠеӨ§жЁЎеһӢеңЁи·Ёд»»еҠЎдёӯд»ӨдәәжғҠиүізҡ„иЎЁзҺ°жҳҜеӯҰжңҜз•Ңйқўдёҙзҡ„иҝ«еҲҮжҢ‘жҲҳд№ӢдёҖ гҖӮдёҚеҗҢдәҺдј з»ҹзҡ„жңәеҷЁеӯҰд№ жҲ–иҖ…ж·ұеәҰеӯҰд№ жЁЎеһӢпјҢи¶…еӨ§зҡ„жЁЎеһӢжһ¶жһ„е’Ңжө·йҮҸзҡ„еӯҰд№ иө„ж–ҷдҪҝеҫ—еӨ§жЁЎеһӢе…·еӨҮдәҶејәеӨ§зҡ„жҺЁзҗҶжіӣеҢ–иғҪеҠӣ гҖӮеӨ§иҜӯиЁҖжЁЎеһӢ (LLMs) жҸҗдҫӣеҸҜи§ЈйҮҠжҖ§зҡ„еҮ дёӘдё»иҰҒйҡҫзӮ№еҢ…жӢ¬:

- жЁЎеһӢеӨҚжқӮжҖ§й«ҳ гҖӮеҢәеҲ«дәҺ LLM ж—¶д»Јд№ӢеүҚзҡ„ж·ұеәҰеӯҰд№ жЁЎеһӢжҲ–иҖ…дј з»ҹзҡ„з»ҹи®ЎжңәеҷЁеӯҰд№ жЁЎеһӢпјҢLLMs жЁЎеһӢ规模巨еӨ§пјҢеҢ…еҗ«ж•°еҚҒдәҝдёӘеҸӮж•°пјҢе…¶еҶ…йғЁиЎЁзӨәе’ҢжҺЁзҗҶиҝҮзЁӢйқһеёёеӨҚжқӮпјҢеҫҲйҡҫй’ҲеҜ№е…¶е…·дҪ“зҡ„иҫ“еҮәз»ҷеҮәи§ЈйҮҠ гҖӮ

- ж•°жҚ®дҫқиө–жҖ§ејә гҖӮLLMs еңЁи®ӯз»ғиҝҮзЁӢдёӯдҫқиө–еӨ§и§„жЁЎж–Үжң¬иҜӯж–ҷ пјҢ иҝҷдәӣи®ӯз»ғж•°жҚ®дёӯзҡ„еҒҸи§ҒгҖҒй”ҷиҜҜзӯүйғҪеҸҜиғҪеҪұе“ҚжЁЎеһӢпјҢдҪҶеҫҲйҡҫе®Ңж•ҙеҲӨж–ӯи®ӯз»ғж•°жҚ®зҡ„иҙЁйҮҸеҜ№жЁЎеһӢзҡ„еҪұе“Қ гҖӮ

- й»‘з®ұжҖ§иҙЁ гҖӮжҲ‘们йҖҡеёёжҠҠ LLMs зңӢеҒҡй»‘з®ұжЁЎеһӢпјҢеҚідҪҝжҳҜеҜ№дәҺејҖжәҗзҡ„жЁЎеһӢжқҘиҜҙпјҢжҜ”еҰӮ Llama-2 гҖӮжҲ‘们еҫҲйҡҫжҳҫејҸең°еҲӨж–ӯе®ғзҡ„еҶ…йғЁжҺЁзҗҶй“ҫе’ҢеҶізӯ–иҝҮзЁӢпјҢеҸӘиғҪж №жҚ®иҫ“е…Ҙиҫ“еҮәиҝӣиЎҢеҲҶжһҗпјҢиҝҷз»ҷеҸҜи§ЈйҮҠжҖ§еёҰжқҘеӣ°йҡҫ гҖӮ

- иҫ“еҮәдёҚзЎ®е®ҡжҖ§ гҖӮLLMs зҡ„иҫ“еҮәеёёеёёеӯҳеңЁдёҚзЎ®е®ҡжҖ§пјҢеҜ№еҗҢдёҖиҫ“е…ҘеҸҜиғҪдә§з”ҹдёҚеҗҢиҫ“еҮәпјҢиҝҷд№ҹеўһеҠ дәҶеҸҜи§ЈйҮҠжҖ§зҡ„йҡҫеәҰ гҖӮ

- иҜ„дј°жҢҮж ҮдёҚи¶і гҖӮзӣ®еүҚеҜ№иҜқзі»з»ҹзҡ„иҮӘеҠЁиҜ„дј°жҢҮж ҮиҝҳдёҚи¶ід»Ҙе®Ңж•ҙеҸҚжҳ жЁЎеһӢзҡ„еҸҜи§ЈйҮҠжҖ§ пјҢ йңҖиҰҒжӣҙеӨҡиҖғиҷ‘дәәзұ»зҗҶи§Јзҡ„иҜ„дј°жҢҮж Ү гҖӮ

дёәдәҶжӣҙеҘҪзҡ„еҪ’зәіжҖ»з»“еӨ§жЁЎеһӢзҡ„еҸҜи§ЈйҮҠжҖ§пјҢжҲ‘们е°Ҷ BERT еҸҠд»ҘдёҠзә§еҲ«зҡ„еӨ§жЁЎеһӢзҡ„и®ӯз»ғиҢғејҸеҲҶдёәдёӨз§Қпјҡ1пјүдј з»ҹ fine-tuning иҢғејҸпјӣ2пјүеҹәдәҺ prompting зҡ„иҢғејҸ гҖӮ

дј з»ҹ fine-tuning иҢғејҸ

еҜ№дәҺдј з»ҹ fine-tuning иҢғејҸпјҢйҰ–е…ҲеңЁдёҖдёӘиҫғеӨ§зҡ„жңӘж Үи®°зҡ„ж–Үжң¬еә“дёҠйў„и®ӯз»ғдёҖдёӘеҹәзЎҖиҜӯиЁҖжЁЎеһӢпјҢеҶҚйҖҡиҝҮжқҘиҮӘзү№е®ҡйўҶеҹҹзҡ„ж Үи®°ж•°жҚ®йӣҶиҝӣиЎҢ fine-tuning гҖӮеёёи§Ғзҡ„жӯӨзұ»жЁЎеһӢжңү BERT, RoBERTa, ELECTRA, DeBERTa зӯү гҖӮ

еҹәдәҺ prompting зҡ„иҢғејҸ

еҹәдәҺ prompting зҡ„иҢғејҸйҖҡиҝҮдҪҝз”Ё prompts е®һзҺ° zero-shot жҲ–иҖ… few-shot learning гҖӮдёҺдј з»ҹ fine-tuning иҢғејҸзӣёеҗҢпјҢйңҖиҰҒйў„и®ӯз»ғеҹәзЎҖжЁЎеһӢ гҖӮдҪҶжҳҜпјҢеҹәдәҺ prompting иҢғејҸзҡ„еҫ®и°ғйҖҡеёёз”ұ instruction tuning е’Ң reinforcement learning from human feedback (RLHF) е®һзҺ° гҖӮеёёи§Ғзҡ„жӯӨзұ»жЁЎеһӢеҢ…жӢ¬ GPT-3.5, GPT 4, Claude, LLaMA-2-Chat, Alpaca, Vicuna зӯү гҖӮе…¶и®ӯз»ғжөҒзЁӢеҰӮдёӢеӣҫпјҡ

еҹәдәҺдј з»ҹ fine-tuning иҢғејҸзҡ„жЁЎеһӢи§ЈйҮҠ

еҹәдәҺдј з»ҹ fine-tuning иҢғејҸзҡ„жЁЎеһӢи§ЈйҮҠеҢ…жӢ¬еҜ№еҚ•дёӘйў„жөӢзҡ„и§ЈйҮҠпјҲеұҖйғЁи§ЈйҮҠпјүе’ҢеҜ№жЁЎеһӢз»“жһ„зә§еҲ«з»„еҲҶеҰӮзҘһз»Ҹе…ғпјҢзҪ‘з»ңеұӮзӯүзҡ„и§ЈйҮҠпјҲе…ЁеұҖи§ЈйҮҠпјү гҖӮ

еұҖйғЁи§ЈйҮҠ

еұҖйғЁи§ЈйҮҠеҜ№еҚ•дёӘж ·жң¬йў„жөӢиҝӣиЎҢи§ЈйҮҠ гҖӮе…¶и§ЈйҮҠж–№жі•еҢ…жӢ¬зү№еҫҒеҪ’еӣ пјҲfeature attributionпјүгҖҒеҹәдәҺжіЁж„ҸеҠӣжңәеҲ¶зҡ„и§ЈйҮҠпјҲattention-basedпјүгҖҒеҹәдәҺж ·жң¬зҡ„и§ЈйҮҠпјҲexample-basedпјүгҖҒеҹәдәҺиҮӘ然иҜӯиЁҖзҡ„и§ЈйҮҠпјҲnatural language explanationпјү гҖӮ

ж–Үз« жҸ’еӣҫ

1. зү№еҫҒеҪ’еӣ ж—ЁеңЁиЎЎйҮҸжҜҸдёӘиҫ“е…Ҙзү№еҫҒпјҲдҫӢеҰӮеҚ•иҜҚгҖҒзҹӯиҜӯгҖҒж–Үжң¬иҢғеӣҙпјүдёҺжЁЎеһӢйў„жөӢзҡ„зӣёе…іжҖ§ гҖӮзү№еҫҒеҪ’еӣ ж–№жі•еҸҜд»ҘеҲҶзұ»дёәпјҡ

- еҹәдәҺжү°еҠЁзҡ„и§ЈйҮҠпјҢйҖҡиҝҮдҝ®ж”№е…¶дёӯзү№е®ҡзҡ„иҫ“е…Ҙзү№еҫҒи§ӮеҜҹеҜ№иҫ“еҮәз»“жһңзҡ„еҪұе“Қпјӣ

- еҹәдәҺжўҜеәҰзҡ„и§ЈйҮҠпјҢе°Ҷиҫ“еҮәеҜ№иҫ“е…Ҙзҡ„еҒҸеҫ®еҲҶдҪңдёәзӣёеә”иҫ“е…Ҙзҡ„йҮҚиҰҒжҖ§жҢҮж Үпјӣ

- жӣҝд»ЈжЁЎеһӢпјҢдҪҝз”Ёз®ҖеҚ•зҡ„дәәзұ»еҸҜзҗҶи§Јзҡ„жЁЎеһӢеҺ»жӢҹеҗҲеӨҚжқӮжЁЎеһӢзҡ„еҚ•дёӘиҫ“еҮәпјҢд»ҺиҖҢиҺ·еҸ–еҗ„иҫ“е…Ҙзҡ„йҮҚиҰҒжҖ§пјӣ

- еҹәдәҺеҲҶи§Јзҡ„жҠҖжңҜ пјҢ ж—ЁеңЁе°Ҷзү№еҫҒзӣёе…іжҖ§еҫ—еҲҶиҝӣиЎҢзәҝжҖ§еҲҶи§Ј гҖӮ

жҺЁиҚҗйҳ…иҜ»

- ж•°жҚ®ж ҮжіЁе‘ҳпјҢеӣ°еңЁеӨ§жЁЎеһӢйҮҢ

- еӣӣжқЎе»әи®®пјҢжү“йҖ зІҫз®ҖгҖҒеј№жҖ§гҖҒеҸҜз»ҙжҠӨзҡ„Androidжһ¶жһ„

- еӨҡжЁЎжҖҒеӨ§жЁЎеһӢжңҖе…Ёз»јиҝ°жқҘдәҶпјҒ7дҪҚеҫ®иҪҜз ”з©¶е‘ҳеӨ§еҠӣеҗҲдҪңпјҢ5еӨ§дё»йўҳпјҢжҲҗж–Ү119йЎө

- жҜҸеӨ©еҗғ 1 дёӘжўЁеҘҪеӨ„еҸҜеӨӘеӨҡдәҶпјҒ

- й”ЎзәёйҖүзғ§зғӨеҠҹиғҪеҸҜз”Ё

- иӮҜеҫ·еҹә иӮҜеҫ·еҹәеҮ зӮ№еҸҜд»ҘзӮ№жӯЈйӨҗ

- жқЁжў…жңүй•ҝжҜӣ жҙ—е®ҢиғҪеҗғеҗ—пјҹжқЁжў…жңүй•ҝй•ҝзҡ„зҷҪжҜӣеҸҜд»Ҙз”ЁжқҘжіЎй…’еҗ—пјҹ

- еҸ‘йңүзҡ„жқЁжў…з…®зҶҹдәҶиҝҳиғҪеҗғеҗ—пјҹжқЁжў…еҸ‘йңүдәҶеҸҜд»ҘжіЎй…’еҗ—пјҹ

- жҰҙиҺІеҗҺеҸҜд»ҘеҗғиҠ’жһңеҗ—пјҹжҰҙиҺІд№ӢеҗҺеҸҜд»ҘеҗғйҰҷи•үеҗ—пјҹ

- жқЁжў…еҸҜд»ҘеҶ·еҶ»дҝқеӯҳеҗ—пјҹеҶ·еҶ»жқЁжў…жҖҺд№Ҳеҗғпјҹ