但是 , 因为每个API都有一个predict()方法 , 所以每个API都有相同数量的路由—1 。假设这允许Cortex在基础设施层面做更多的事情 , 而不限制工程师 。

3.服务模型只是一个微服务对于在生产中使用机器学习的人来说 , 规模是一个主要的问题 。型号可能会很大(GPT-2大约是6 GB) , 计算成本高 , 并且可能有很高的延迟 。特别是对于实时推断 , 扩大规模来处理流量是一项挑战——如果你的预算有限 , 情况更是如此 。

为了解决这个问题 , Cortex把预测器当作微型服务 , 可以水平伸缩 。更具体地说 , 当开发人员进行Cortex部署时 , Cortex将包含API , 旋转为推理准备的集群 , 并进行部署 。然后 , 它将API公开为负载平衡器背后的web服务 , 并配置自动缩放、更新和监视:

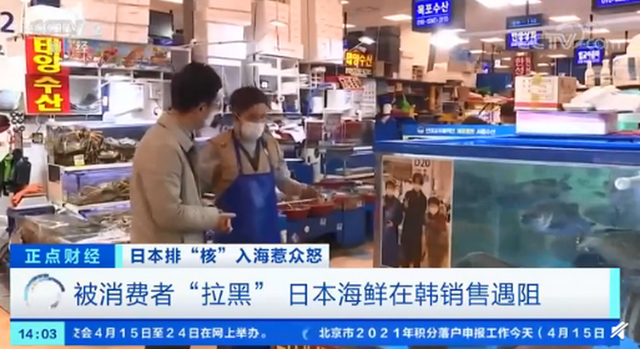

文章插图

预测器接口是此过程的基础 , 尽管它“只是”一个Python接口 。

预测器接口所做的是强制打包代码 , 使其成为推理的单个原子单元 。单个API所需的所有请求处理代码都包含在一个预测器中 。这使得大脑皮层能够很容易地衡量预测因素 。

通过这种方式 , 工程师不必做任何额外的工作——当然 , 除非他们想做一些调整——准备一个用于生产的API 。一个皮层的部署是默认的生产准备就绪 。

英文原文:

https://towardsdatascience.com/designing-a-python-interface-for-machine-learning-engineering-ae308adc4412

推荐阅读

- 老鹰茶如何泡,海马宫茶属于哪类茶

- 如何和红颜知己相处

- 教你如何鉴别真假茶,雪菊茶真假鉴别

- 如何清除文件中的数据?

- 如果南明没有灭亡 南明王朝存在多少年

- 冬季如何防治老年人慢性支气管炎

- 立冬日出生的人有什么说法吗? 立冬出生的人命运如何

- 晏子与景公是怎样的人 晏子谏齐景公,晏子是个什么样的人

- 马恩岛猫如何选购

- 逆风如解意容易莫摧残什么意思?