ж–Үз« жҸ’еӣҫ

жӯӨж—¶д»–дјҡе…Ҳи·ҹNameNodeйҖҡдҝЎпјҢиҜҙпјҡеӨ§е“ҘпјҢжҲ‘жғіеҲӣе»әдёҖдёӘж–°зҡ„ж–Ү件пјҢд»–зҡ„еҗҚеӯ—еҸ«“/usr/hive/warehouse/access_20180101.log”пјҢеӨ§е°ҸжҳҜ1TBпјҢдҪ зңӢиЎҢдёҚпјҹ

然еҗҺNameNodeе°ұдјҡеңЁиҮӘе·ұеҶ…еӯҳзҡ„ж–Ү件зӣ®еҪ•ж ‘йҮҢпјҢеңЁжҢҮе®ҡзҡ„зӣ®еҪ•дёӢжҗһдёҖдёӘж–°зҡ„ж–Ү件еҜ№иұЎпјҢеҗҚеӯ—е°ұжҳҜ“access_20180101.log” гҖӮ

иҝҷдёӘж–Ү件зӣ®еҪ•ж ‘дёҚе°ұжҳҜHDFSйқһеёёж ёеҝғзҡ„дёҖеқ—е…ғж•°жҚ®пјҢз»ҙжҠӨдәҶHDFSиҝҷдёӘеҲҶеёғејҸж–Ү件系з»ҹдёӯпјҢжңүе“Әдәӣзӣ®еҪ•пјҢжңүе“Әдәӣж–Ү件пјҢеҜ№дёҚеҜ№пјҹ

дҪҶжҳҜжңүдёӘй—®йўҳпјҢиҝҷдёӘж–Ү件зӣ®еҪ•ж ‘жҳҜеңЁNameNodeзҡ„еҶ…еӯҳйҮҢзҡ„е•ҠпјҒ

иҝҷеҸҜеқ‘зҲ№дәҶпјҢдҪ жҠҠйҮҚиҰҒзҡ„е…ғж•°жҚ®йғҪж”ҫеңЁеҶ…еӯҳйҮҢпјҢдёҮдёҖNameNodeдёҚе°Ҹеҝғе®•жңәдәҶеҸҜе’Ӣж•ҙпјҹе…ғж•°жҚ®дёҚе°ұе…ЁйғЁдёўеӨұдәҶпјҹ

еҸҜдҪ иҰҒжҳҜжҜҸж¬ЎйғҪйў‘з№Ғзҡ„дҝ®ж”№зЈҒзӣҳж–Ү件йҮҢзҡ„е…ғж•°жҚ®пјҢжҖ§иғҪиӮҜе®ҡжҳҜжһҒдҪҺзҡ„е•ҠпјҒжҜ•з«ҹиҝҷжҳҜеӨ§йҮҸзҡ„зЈҒзӣҳйҡҸжңәиҜ»еҶҷпјҒ

жІЎе…ізі»пјҢжҲ‘们жқҘзңӢзңӢHDFSдјҳйӣ…зҡ„и§ЈеҶіж–№жЎҲ гҖӮ

жҜҸж¬ЎеҶ…еӯҳйҮҢж”№е®ҢдәҶпјҢеҶҷдёҖжқЎedits logпјҢе…ғж•°жҚ®дҝ®ж”№зҡ„ж“ҚдҪңж—Ҙеҝ—еҲ°зЈҒзӣҳж–Ү件йҮҢпјҢдёҚдҝ®ж”№зЈҒзӣҳж–Ү件еҶ…е®№пјҢе°ұжҳҜйЎәеәҸиҝҪеҠ пјҢиҝҷдёӘжҖ§иғҪе°ұй«ҳеӨҡдәҶ гҖӮ

жҜҸж¬ЎNameNodeйҮҚеҗҜзҡ„ж—¶еҖҷпјҢжҠҠedits logйҮҢзҡ„ж“ҚдҪңж—Ҙеҝ—иҜ»еҲ°еҶ…еӯҳйҮҢеӣһж”ҫдёҖдёӢпјҢдёҚе°ұеҸҜд»ҘжҒўеӨҚе…ғж•°жҚ®дәҶпјҹ

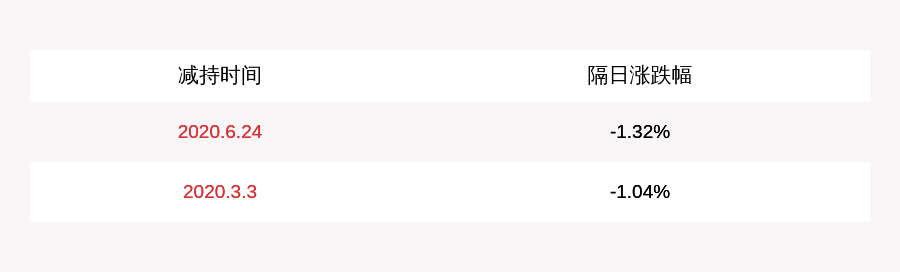

еӨ§е®¶йЎәзқҖдёҠйқўзҡ„ж–Үеӯ—пјҢжҠҠж•ҙдёӘиҝҮзЁӢпјҢз”ЁдёӢйқўиҝҷеј еӣҫи·ҹзқҖиө°дёҖйҒҚ гҖӮ

ж–Үз« жҸ’еӣҫ

дҪҶжҳҜй—®йўҳеҸҲжқҘдәҶпјҢйӮЈedits logеҰӮжһңи¶ҠжқҘи¶ҠеӨ§зҡ„иҜқпјҢеІӮдёҚжҳҜжҜҸж¬ЎйҮҚеҗҜйғҪдјҡеҫҲж…ўпјҹеӣ дёәиҰҒиҜ»еҸ–еӨ§йҮҸзҡ„edits logеӣһж”ҫжҒўеӨҚе…ғж•°жҚ®пјҒ

жүҖд»ҘHDFSиҜҙпјҢжҲ‘еҸҜд»Ҙиҝҷж ·еӯҗе•ҠпјҢжҲ‘еј•е…ҘдёҖдёӘж–°зҡ„зЈҒзӣҳж–Ү件еҸ«еҒҡfsimageпјҢ然еҗҺе‘ўпјҢеҶҚеј•е…ҘдёҖдёӘJournalNodesйӣҶзҫӨпјҢд»ҘеҸҠдёҖдёӘStandby NameNodeпјҲеӨҮиҠӮзӮ№пјү гҖӮ

жҜҸж¬ЎActive NameNodeпјҲдё»иҠӮзӮ№пјүдҝ®ж”№дёҖж¬Ўе…ғж•°жҚ®йғҪдјҡз”ҹжҲҗдёҖжқЎedits logпјҢйҷӨдәҶеҶҷе…Ҙжң¬ең°зЈҒзӣҳж–Ү件пјҢиҝҳдјҡеҶҷе…ҘJournalNodesйӣҶзҫӨ гҖӮ

然еҗҺStandby NameNodeе°ұеҸҜд»Ҙд»ҺJournalNodesйӣҶзҫӨжӢүеҸ–edits logпјҢеә”з”ЁеҲ°иҮӘе·ұеҶ…еӯҳзҡ„ж–Ү件зӣ®еҪ•ж ‘йҮҢпјҢи·ҹActive NameNodeдҝқжҢҒдёҖиҮҙ гҖӮ

然еҗҺжҜҸйҡ”дёҖж®өж—¶й—ҙпјҢStandby NameNodeйғҪжҠҠиҮӘе·ұеҶ…еӯҳйҮҢзҡ„ж–Ү件зӣ®еҪ•ж ‘еҶҷдёҖд»ҪеҲ°зЈҒзӣҳдёҠзҡ„fsimageпјҢиҝҷеҸҜдёҚжҳҜж—Ҙеҝ—пјҢиҝҷжҳҜе®Ңж•ҙзҡ„дёҖд»Ҫе…ғж•°жҚ® гҖӮиҝҷдёӘж“ҚдҪңе°ұжҳҜжүҖи°“зҡ„checkpointжЈҖжҹҘзӮ№ж“ҚдҪң гҖӮ

然еҗҺжҠҠиҝҷдёӘfsimageдёҠдј еҲ°еҲ°Active NameNodeпјҢжҺҘзқҖжё…з©әжҺүActive NameNodeзҡ„ж—§зҡ„edits logж–Ү件пјҢиҝҷйҮҢеҸҜиғҪйғҪжңү100дёҮиЎҢдҝ®ж”№ж—Ҙеҝ—дәҶпјҒ

然еҗҺActive NameNode继з»ӯжҺҘ收дҝ®ж”№е…ғж•°жҚ®зҡ„иҜ·жұӮпјҢеҶҚеҶҷе…Ҙedits logпјҢеҶҷдәҶдёҖе°Ҹдјҡе„ҝпјҢиҝҷйҮҢеҸҜиғҪе°ұеҮ еҚҒиЎҢдҝ®ж”№ж—Ҙеҝ—иҖҢе·ІпјҒ

еҰӮжһңиҜҙжӯӨж—¶пјҢActive NameNodeйҮҚеҗҜдәҶпјҢbingoпјҒжІЎе…ізі»пјҢеҸӘиҰҒжҠҠStandby NameNodeдј иҝҮжқҘзҡ„fsimageзӣҙжҺҘиҜ»еҲ°еҶ…еӯҳйҮҢпјҢиҝҷдёӘfsimageзӣҙжҺҘе°ұжҳҜе…ғж•°жҚ®пјҢдёҚйңҖиҰҒеҒҡд»»дҪ•йўқеӨ–ж“ҚдҪңпјҢзәҜиҜ»еҸ–пјҢж•ҲзҺҮеҫҲй«ҳпјҒ

然еҗҺжҠҠж–°зҡ„edits logйҮҢе°‘йҮҸзҡ„еҮ еҚҒиЎҢзҡ„дҝ®ж”№ж—Ҙеҝ—еӣһж”ҫеҲ°еҶ…еӯҳйҮҢе°ұokдәҶпјҒ

иҝҷдёӘиҝҮзЁӢзҡ„еҗҜеҠЁйҖҹеәҰе°ұеҝ«зҡ„еӨҡдәҶпјҒеӣ дёәдёҚйңҖиҰҒеӣһж”ҫеӨ§йҮҸдёҠзҷҫдёҮиЎҢзҡ„edits logжқҘжҒўеӨҚе…ғж•°жҚ®дәҶпјҒеҰӮдёӢеӣҫжүҖзӨә гҖӮ

ж–Үз« жҸ’еӣҫ

жӯӨеӨ–пјҢеӨ§е®¶зңӢзңӢдёҠйқўиҝҷеј еӣҫпјҢзҺ°еңЁе’ұ们жңүдҝ©NameNode гҖӮ

- дёҖдёӘжҳҜдё»иҠӮзӮ№еҜ№еӨ–жҸҗдҫӣжңҚеҠЎжҺҘ收иҜ·жұӮ

- еҸҰеӨ–дёҖдёӘзәҜе°ұжҳҜжҺҘ收е’ҢеҗҢжӯҘдё»иҠӮзӮ№зҡ„edits logд»ҘеҸҠжү§иЎҢе®ҡжңҹcheckpointзҡ„еӨҮиҠӮзӮ№ гҖӮ

жүҖд»Ҙе‘ўпјҢеҰӮжһңActive NameNodeжҢӮдәҶпјҢжҳҜдёҚжҳҜеҸҜд»Ҙз«Ӣ马еҲҮжҚўжҲҗStandby NameNodeеҜ№еӨ–жҸҗдҫӣжңҚеҠЎпјҹ

иҝҷдёҚе°ұжҳҜжүҖи°“зҡ„NameNodeдё»еӨҮй«ҳеҸҜз”Ёж•…йҡңиҪ¬з§»жңәеҲ¶д№ҲпјҒ

жҺҘдёӢжқҘеӨ§е®¶еҶҚжғіжғіпјҢHDFSе®ўжҲ·з«ҜеңЁNameNodeеҶ…еӯҳйҮҢзҡ„ж–Ү件зӣ®еҪ•ж ‘пјҢж–°еҠ дәҶдёҖдёӘж–Ү件 гҖӮ

дҪҶжҳҜиҝҷдёӘж—¶еҖҷпјҢдәә家иҰҒжҠҠж•°жҚ®дёҠдј еҲ°еӨҡеҸ°DataNodeжңәеҷЁдёҠеҺ»е•ҠпјҢиҝҷеҸҜжҳҜдёҖдёӘ1TBзҡ„еӨ§ж–Ү件пјҒе’Ӣдј е‘ўпјҹ

еҫҲз®ҖеҚ•пјҢжҠҠ1TBзҡ„еӨ§ж–Ү件жӢҶжҲҗNдёӘblockпјҢжҜҸдёӘblockжҳҜ128MB гҖӮ1TB = 1024GB = 1048576MBпјҢдёҖдёӘblockжҳҜ128MBпјҢйӮЈд№Ҳе°ұжҳҜеҜ№еә”зқҖ8192дёӘblock гҖӮ

иҝҷдәӣblockдјҡеҲҶеёғеңЁдёҚеҗҢзҡ„жңәеҷЁдёҠз®ЎзҗҶзқҖпјҢжҜ”еҰӮиҜҙдёҖе…ұжңү100еҸ°жңәеҷЁз»„жҲҗзҡ„йӣҶзҫӨпјҢйӮЈд№ҲжҜҸеҸ°жңәеҷЁдёҠж”ҫ80дёӘе·ҰеҸізҡ„blockе°ұokдәҶ гҖӮ

дҪҶжҳҜй—®йўҳеҸҲжқҘдәҶпјҢйӮЈеҰӮжһңиҝҷдёӘж—¶еҖҷ1еҸ°жңәеҷЁе®•жңәдәҶпјҢдёҚе°ұеҜјиҮҙ80дёӘblockдёўеӨұдәҶпјҹ

д№ҹе°ұжҳҜиҜҙдёҠдј дёҠеҺ»зҡ„1TBзҡ„еӨ§ж–Ү件пјҢдјҡдёўеӨұдёҖе°ҸйғЁеҲҶж•°жҚ®е•Ҡ гҖӮжІЎе…ізі»пјҒHDFSйғҪиҖғиҷ‘еҘҪдәҶпјҒ

е®ғдјҡй»ҳи®Өз»ҷжҜҸдёӘblockжҗһ3дёӘеүҜжң¬пјҢдёҖжЁЎдёҖж ·зҡ„еүҜжң¬пјҢеҲҶж”ҫеңЁдёҚеҗҢзҡ„жңәеҷЁдёҠпјҢеҰӮжһңдёҖеҸ°жңәеҷЁе®•жңәдәҶпјҢеҗҢдёҖдёӘblockиҝҳжңүеҸҰеӨ–дёӨдёӘеүҜжң¬еңЁе…¶д»–жңәеҷЁдёҠе‘ўпјҒ

еӨ§дјҷе„ҝзңӢзңӢдёӢйқўиҝҷеј еӣҫ гҖӮжҜҸдёӘblockйғҪеңЁдёҚеҗҢзҡ„жңәеҷЁдёҠжңү3дёӘеүҜжң¬пјҢд»»дҪ•дёҖеҸ°жңәеҷЁе®•жңәйғҪжІЎдәӢпјҒиҝҳеҸҜд»Ҙд»Һе…¶д»–зҡ„жңәеҷЁдёҠжӢҝеҲ°йӮЈдёӘblock гҖӮ

иҝҷдёӢеӯҗпјҢдҪ еҫҖHDFSдёҠдј дёҖдёӘ1TBзҡ„еӨ§ж–Ү件пјҢеҸҜд»Ҙй«ҳжһ•ж— еҝ§дәҶеҗ§пјҒ

жҺЁиҚҗйҳ…иҜ»

- й…ёжұӨйұј

- е‘Ёе…¬и§ЈжўҰжўҰи§ҒеҸ‘йқўж»Ўж»ЎдёҖеӨ§зӣҶ жўҰи§ҒеҸ‘дәҶдёҖзӣҶйқўйқўйғҪжәўеҮәжқҘдәҶ

- еҷЁдёәиҢ¶з”ҹ зӣ–зў—жҳҜжңҖдҪізҡ„жіЎиҢ¶еҷЁе…·зҡ„е…«еӨ§зҗҶз”ұ

- жўҰи§Ғд»Һең°дёӢеҫҖдёҠе–·зҒ« жўҰи§ҒеӨ§зҒ«д»Һең°дёӢе–·еҮә

- иҸ©жҸҗзҘ–еёҲи·ҹй•Үе…ғеӨ§д»ҷи°ҒеҺүе®і иҸ©жҸҗиҖҒзҘ–е’Ңй•Үе…ғеӨ§д»ҷи°ҒеҺүе®і

- иҮӘеҠЁй©ҫ驶|з”·еӯҗеқ еҙ–200зұі5еӨ©еҗҺеҘҮиҝ№з”ҹиҝҳ йқ е–қйӣЁж°ҙгҖҒеҗғйҮҺжһңпјҡзҪ‘еҸӢжғҠеҸ№е‘ҪзңҹеӨ§

- ж·ҳе®қе®ўжңҚе…«еӨ§йӣ·еҢә ж·ҳе®қеӨ©зҢ«и§„еҲҷдёӯеёёи§Ғзҡ„йӣ·еҢәжңүе“Әдәӣ

- жЈ•еһ«еҚҒеӨ§е“ҒзүҢжңҖж–°жҺ’иЎҢжҰң

- дё–з•ҢдёҠжңҖеӨ§зҡ„йҮ‘жҳҜд»Җд№ҲйҮ‘ дё–з•ҢдёҠжңҖдҫҝе®ңзҡ„йҮ‘еӯҗжҳҜд»Җд№ҲйҮ‘?

- иӣӢз…ҺеӨҡжҳҘйұј